Dinamica

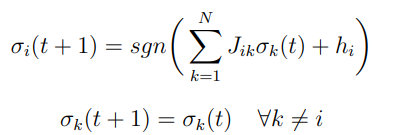

Possiamo introdurre una dinamica discreta tra stati di una rete di McCulloch-Pitts neuron :

Si può pensare a come un tempo refrattario dei neuroni biologici.

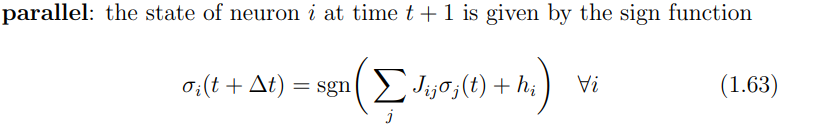

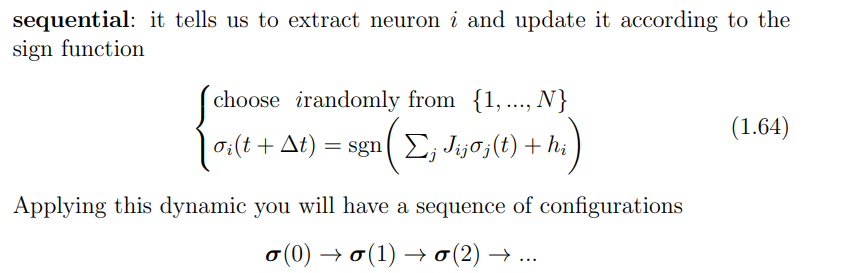

Ci sono due maniera di realizzare questa dinamica:

- Dinamica parallela Gli stati evolvono tutti insiemi;

- Dinamica sequenziale Si sceglie un neurone e si aggiorna solo quello.

Noiseless recurrent networks

Studiamo la dinamica nel caso noiseless per i casi

Parallel dynamics

Es 1 Caso banale: e . La regola di update è banale, non dipende dallo stato precedente, dopo una iterazione tutto il sistema va nello stato finale:

Il bacino di attrazione per questo stato punto fisso è tutto il dominio .

Es 2

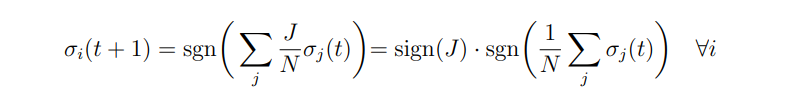

Supponiamo ora e , ovvero interazioni simmetriche e campo esterno nullo.

Otteniamo la regola di update:

Notiamo come compare un’osservabile macroscopica, la magnetizzazzione media (spin medio):

Notiamo come compare un’osservabile macroscopica, la magnetizzazzione media (spin medio):

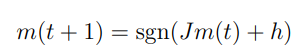

Possiamo ottenere una formula di update per questa osservabile macroscopica sommando:

Se , abbiamo una dinamica imitatoria: i neuroni tendono a fare quello che fanno gli altri. Partizioniamo le configurazioni in:

(supponiamo di avere un numero dispari di neuroni, così non abbiamo il caso patologico ).

Abbiamo punti fissi e che corrispondono a e .

Se abbiamo un ciclo limite di periodo due tra stati ed .

Es 3

Caso e .

La regola di update della magnetizzazzione media è:

Se il campo esterno è troppo forte, ovvero otteniamo una dinamica banale, come nel caso senza interazioni.

Con otteniamo sempre due punti fissi, ma con bacini d’attrazione non uguali e che dipendono dal rapporto .

Con otteniamo sempre un ciclo di periodo due, controlla quanto ci metto a raggiungere il ciclo.

Sequential dynamics

Studiamo gli stati limite tramite Funzioni di Lyapunov.

Proposizione Se abbiamo interazioni simmetriche , ed autointerazioni non negative , un campo esterno e noisless (), allora

è una funzione di Lyapunov della dinamica sequenziale:

dove si estrae uniformemente in .

Durante la dinamica la funzione evolve:

Siccome è limitata inferiormente, ammette un minimo ed il sistema arriverà a queste configurazioni e si fermerà. (Richiediamo distanza di hamming ).

Pattern retrival

Possiamo vedere questa abilità delle reti di “ricordare” informazioni , dato un input iniziale , sfruttando questa dinamica verso attrattori.

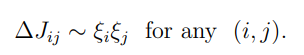

Basando sulla regola (principio) di Hebb:

Neurons that fire together wire together Neurons out of sync fail to link

Risulta ragionevole:

Si vede facilmente che possiamo memorizzare singoli pattern definendo le connessioni in accordo con la regola di Hebb. Aggiungere campo esterno complica le cose, valgono le stesse considerazioni fatte nella dinamica parallela caso simmetrico con campo esterno. Quindi la rete avrà punti fissi in e , a seconda di .

Si vede facilmente che possiamo memorizzare singoli pattern definendo le connessioni in accordo con la regola di Hebb. Aggiungere campo esterno complica le cose, valgono le stesse considerazioni fatte nella dinamica parallela caso simmetrico con campo esterno. Quindi la rete avrà punti fissi in e , a seconda di .

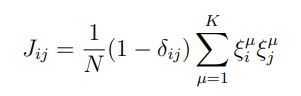

Per più pattern, una scelta ragionevole è mediare:

Per semplificare la trattazzione assumiamo che i pattern siano ortogonali.

Per semplificare la trattazzione assumiamo che i pattern siano ortogonali.

Proposizione La dinamica sequenziale applicata ad una rete con pesi dati dalla regola di Hebb e , mostra stati stazionari, che corrispondono ai pattern ed hai loro inversi.

Dim Scriviamo la funzione di Lyapunov:

con la regola di Hebb e campi esterni nulli

notando che

dunque

Il termine al quadrato non è altro che il prodotto scalare tra lo stato ed il pattern (normalizzato) . Siccome abbiamo supposto per ipotesi che i pattern sono ortogonali, per massimizzare il prodotto scalare deve avere la stessa direzione di , ed in questo caso e zero per gli altri pattern, dunque:

ed il minimo si ottiene quando .

Osservazione Non è vero che tutti i minimi sono pattern, esistono dei minimi spuri.

Proposizione Misture dispari dei pattern sono stati stazionari. Misture pari sono stati stazionario instabili. Sono minimi locali.

Stocasticità

Introduciamo delle perturbazioni random sulla soglia di attivazione, sommando una variabile a media nulla:

dove è la deviazione standard, una variabile a media nulla e varianza unitaria. Il parametro controlla dunque il grado di stocasticità (una temperatura).

Effettuiamo anche in cambio da a spin . La regola di update diventa:

da qui si capisce il fattore aggiunto al rumore. La quantità viene detto campo locale.

La probabilità di trovare un neurone nello stato al tempo è dunque una variabile aleatoria che dipende dalle v.a. e dallo stato della rete . Se supponiamo sia simmetrico:

esprimento il tutto in funzione della cumulativa

Con la cumulativa è ; un’altra scelta simile è la tangente iperbolica:

a cui corrisponde un rumore distribuito come:

Per la dinamica parallela, supponendo le variabili indipendenti, la probabilità fattorizza e si ottiene:

Noisy dynamics

Vogliamo studiare il comportamento della rete quando aggiungiamo del rumore nelle soglie di attivazione, come abbiamo precedentemente mostrato. A causa del rumore random, potremmo solo fare considerazioni di carattere probabilistico sul comportamento della rete. Siamo sempre interessati al comportamento limite . E’ chiaro che possiamo studiare lo stato limite tramite le catene di Markov. Sotto opportune ipotesi sulle interazioni, riusciamo a calcolare la distribuzione di equilibrio.

Matrice di transizione della dinamica sequenziale

Abbiamo visto che una scelta sensata per la distribuzione del rumore, è quella con funzione di partizione

essendo molto simile al rumore gaussiano, senza l’impiccio della . Vogliamo trovare la matrice di transizione di dimensione . Se assumiamo di scegliere in maniera uniforme lo spin da aggiornare, affinchè due pattern e abbiamo probabilità positiva devono essere necessariamente a distanza di Hamming uno:

dove il primo termine della sommatoria considera il caso in cui il pattern rimane lo stesso, il secondo nel caso in cui lo spin cambia segno. Con intendiamo lo stato quando e .

Il processo di Markov associato a questa matrice di transizione è ergodico, ovvero indipendnetemente della distribuzione iniziale esiste un tempo finito tale che:

in maniera equivalente

è chiaro che nel nostro caso sequenziale .

Teorema Processi di Markov ergodici hanno un’unica distribuzione stazionario alla quale convergono indipendentemente dalla distribuzione iniziale.

Per calcolare esplicitamente la distribuzione stazionaria, aggiungiamo l’ipotesi di dettaglio bilanciato:

Teorema La dinamica sequenziale senza autointerazioni, e con interazione simmetriche implica il dettaglio bilanciato. La distribuzione stazionaria di equilibrio è data da:

che è proprio la distribuzione di Boltzmann-Gibbs.

Remark L’hamiltoniana è proprio la funzione di Lyapunov del caso noisless, infatti nel limite la distribuzione stazionaria si picca intorno ai minimi di .

Proof* Siamo nelle ipotesi senza autointerazioni ed interazioni simmetriche:

facciamo vedere che questo vale se e solo se vale il bilancio dettagliato

Il caso è triviale. Resta il caso . La condizione di DB diventa

Siccome siamo nell’ipotesi di no autointerazioni i campi locali:

sono indipendenti dal valore di !

Resta da far vedere che

Sfruttiamo il fatto che

studiando all’esponente solo i termini che dipendono da

DB vale se e solo se