The perceptron

Abbiamo visto come reti di neuroni McCulloch-Pitts neuron siano universali, ovvero riescono a rappresentare ogni funzione binaria . Quindi data una funzione, riesco a trovare i parametri dei neuroni tali che la rete replichi perfettamente la funzione.

Ci poniamo ora il problema dell’apprendimento, ovvero come trovare i pesi “migliori” data una conoscenza parziale della funzione .

Online learning

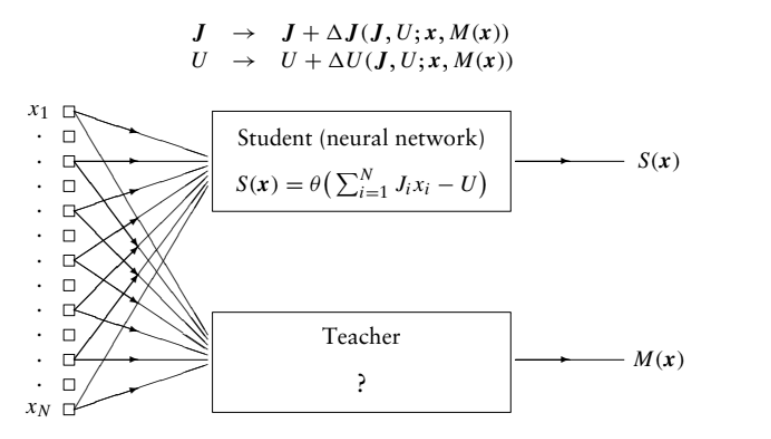

Supponiamo di avere una rete “Maestro” ed una “Studente”, l’obbiettivo è passare la conoscenza perfetta di del maestro allo studente, che all’inizio ha pesi random.

La procedura detta online training:

- Si sceglie random una domanda

- Si confrontano le risposte:

- Se ok

- Se si aggiornano i pesi dello studente con una certa regola

La questione ora è capire quale regola e usare:

The Perceptron learning rule

A perceptron is defined as a MP neuron which learns according to the following rule for updating its parameters:

- e : e

- e : e

La regola è molto semplice: se lo studente ha risposto invece che , devo abbassare l’argomento della funzione theta, chiamato local field :

nel caso opposto, lo incremente.

Teorema convergenza della regola

Se il task è linearmente separabile, allora la procedura converge in un numero finito di passi ad una configurazione stazionaria dove .